llama 3发布刚几天,微软就出手截胡了?

刚刚发布的phi-3系列小模型技术报告,引起ai圈热议。

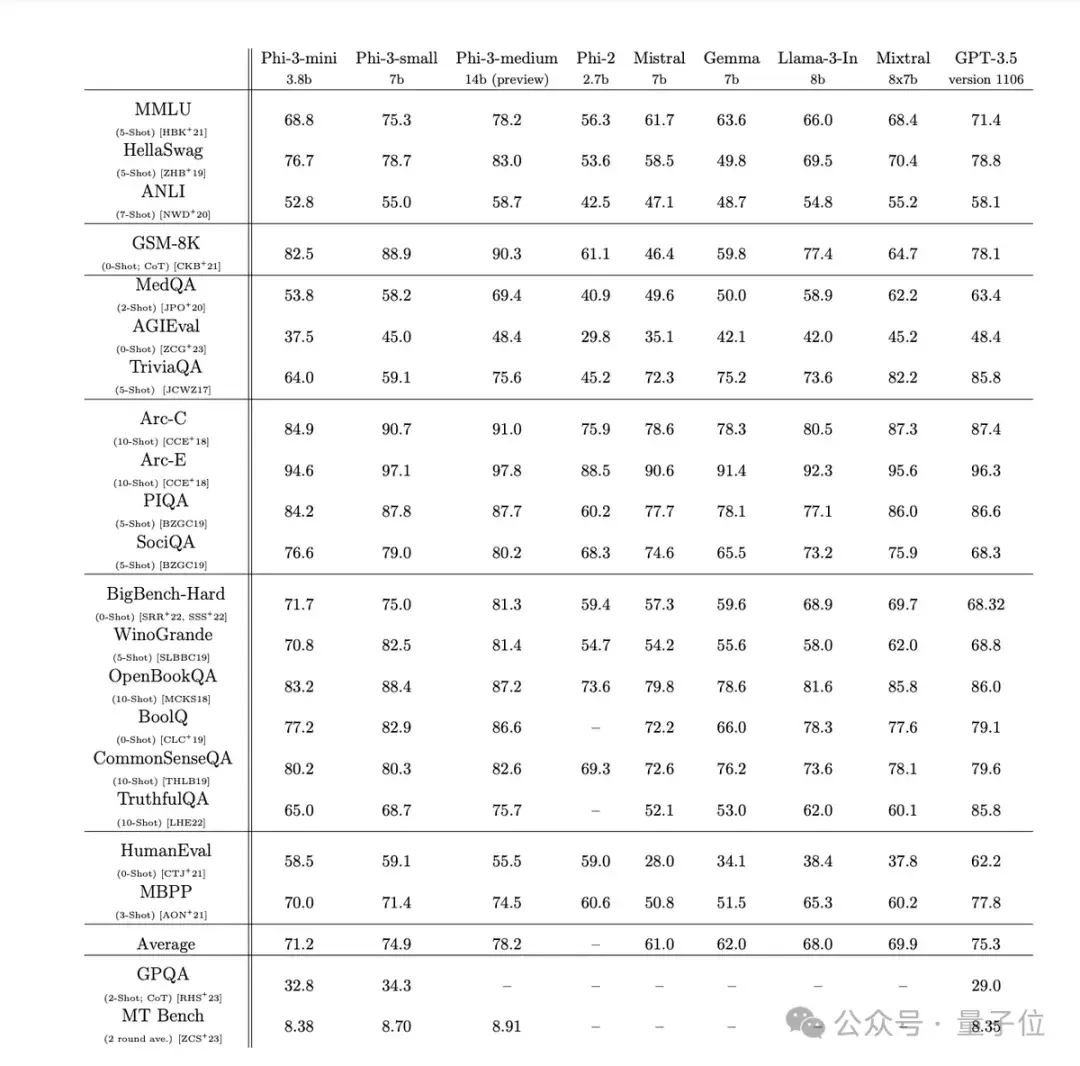

其中仅3.8b参数的phi-3-mini在多项基准测试中超过了llama 3 8b。

为了方便开源社区使用,还特意设计成了与llama系列兼容的结构。

微软这次打出“手机就能直接跑的小模型”的旗号,4bit量化后的phi-3-mini在iphone 14 pro和iphone 15使用的苹果a16芯片上跑到每秒12 token。

这意味着,现在手机上能本地运行的最佳开源模型,已经做到chatgpt水平。

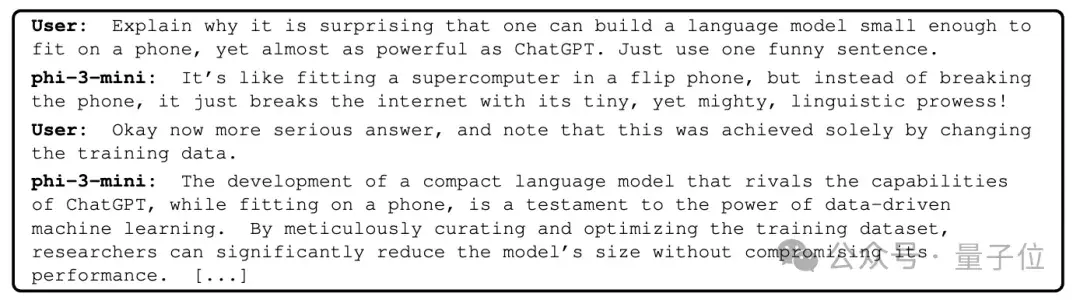

在技术报告中还玩了一把花活,让phi-3-mini自己解释为什么构建小到手机能跑的模型很令人惊叹。

除了mini杯之外,小杯中杯也一并发布:

phi-3-small,7b参数,为支持多语言换用了tiktoken分词器,并额外增加10%多语种数据。

phi-3-medium,14b参数,在更多数据上训练,多数测试中已超越gpt-3.5和mixtral 8x7b moe。

(大杯他们目前不打算做)

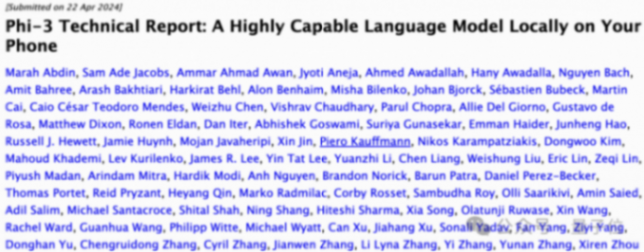

作者阵容一看也不简单,一眼扫过去msra和msr雷蒙德团队都投入了不少人。

那么,phi-3系列到底有什么独特之处呢?

根据技术报告中披露,其核心秘诀就在于数据。

去年团队就发现,单纯堆砌参数量并不是提升模型性能的唯一路径。

反而是精心设计训练数据,尤其是利用大语言模型本身去生成合成数据,配合严格过滤的高质量数据,反而能让中小模型的能力大幅跃升。

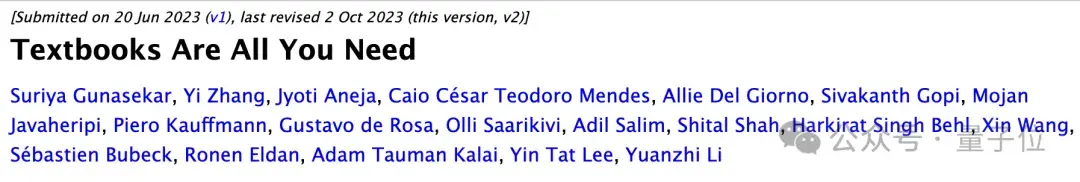

也就是训练阶段只接触教科书级别的高质量数据,textbooks are all you need。

phi-3也延续了这一思路,这次他们更是下了血本:

- 投喂了多达3.3万亿token的训练数据(medium中杯是4.8万亿)

- 大幅强化了数据的”教育水平”过滤

- 更多样化的合成数据,涵盖逻辑推理、知识问答等多种技能

- 独特的指令微调和rlhf训练,大幅提升对话和安全性

举个例子,比如某一天足球比赛的结果可能对于大模型是良好的训练数据,但微软团队删除了这些加强知识的数据,留下更多能提高模型推理能力的数据。

这样一来,对比llama-2系列,就可以用更小的参数获得更高的mmlu测试分数了。